Inledning

Datakvalitet betyder olika saker beroende på syfte och målsättning. För att värdera och uppskatta datakvalitet behövs minst en tilltänkt användargrupp eller tillämpningsområde betraktas vid tillgängliggörande av data. Detta eftersom datakvalitet är kopplat till avsedda användare och vilket dataformat och standarder som används inom olika tillämpningsområden. Datakvalitet är kopplat till kostnader eftersom hög detaljrikedom och noggrannhet oftast kostar mer att tillhandahålla. Oavsett användargrupp eller tillämpningsområde bör all data som tillgängliggörs innehålla metadata som beskriver egenskaper av data, som exempelvis vem som skapat den, när den publicerades, vilka standarder eller enheter som används.

Exempelvis är kalkylblad ett användbart format för finansiell data och PDF dokument passande för offentliga handlingar som skall läsas av människor. Däremot är PDF dokument ett mindre lämpligt format om det skall användas för att publicera mätvärden av exempelvis temperaturobservationer som skall läsas av maskiner.

En kvalitetsaspekt som berör nästan all data oavsett tillämpningsområde är hur aktuell och tidsenlig data är, exempelvis förlorar prognoser om ankommande linjer till en hållplats snabbt sitt värde när avgången inträffat. Länk till principer angående datakvalitet.

Distinktion mellan data och information

Information kan aldrig bli bättre än kvaliteten av den data den härleds ifrån. Enkelt beskrivit är data en enhet fakta som i sig själv inte går att härleda något mening ifrån, däremot kan en mängd data utgöra mening i form av information beroende på hur det tolkas, behandlas och presenteras. En pixel i en bildfil är en enskild enhet data som inte säger något om vad den representerar. Däremot tillsammans kan de representera en bild om de behandlas och presenteras rätt beroende på om metadata finns tillgängligt i filen vilket beskriver exempelvis färgrymd, bildbehandlingsstandard, datum, totalt antal pixlar med mera. I andra fall är distinktionen inte lika tydlig mellan data och information, exempelvis kan en enskild observation av temperatur tolkas och utgöra viss mening. När data om temperatur kombineras med data om geografisk plats, lufttryck, luftfuktighet med metadata om mätenheter, standarder, tidpunkt, mm. så skapas mening och sammanhang.

Exakthet och Precision

Ett sätt att förhålla sig till datakvalitet är att anpassa behovet av exakthet och precision i förhållande till sitt ändamål. Exakthet är hur väl data återger verkligheten, det vill säga hur väl fakta som finns tillhands kan återskapa den ursprungliga innebörden. Behovet av detaljnivå skall sättas i förhållande till ändamålet. Exempelvis kan en lågupplöst satellitbild vara tillräcklig för att se större byggnader och vägar, men inte tillräckligt detaljerad för att se stigar och mindre vägar. Behovet av detaljnivå behöver också sättas i perspektiv till kostnaden eftersom tillhandahållandet av data med hög detaljnivå är oftast förenligt med större kostnader. Förutom val av detaljnivån är det viktigt att välja maskinläsbart format som är lämpade för maskinell behandling och tolkning, mer om innebörden av maskinläsbart format går att läsa i länken nedanför.

… dataformat som är lämpade för resurssnål databehandling med möjligheter att definiera objekt, attribut och hierarkier så att maskiner kan tolka innehåll och kontext utan manuell handpåläggning. – Artikel om maskinläsbart format (15/03/2017)

Exakthet påverkas av faktafel och om data är inkomplett – det vill säga att poster av data saknas eftersom detta skapar brus och att data kvaliteten försämras. Även transformering av data till andra mätenheter kan påverka exaktheten eftersom detaljnivå kan gå förlorad. Generellt sett är det bättre att data tillhålls komplett och i ursprungliga mätenheter så att användare själv kan transformera och sammanställa efter behov.

Precision är hur väl data kan reproducera liknande resultat och betydelse oberoende av vem som tolkar den. Det vill säga att data med hög precision har hög korrelation för det som avses att mätas eller representeras. Dataformat som erbjuder hög precision är oftast hieratisk strukturerade, som exempelvis XML och JSON. Däremot garanterar inte dataformat precision, utan det förlitar sig på noggrannheten i de processer som mäta och samlar data.

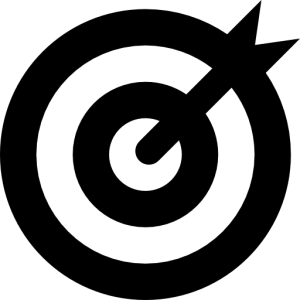

Sammanställningar i form av rapporter och prognoser som inte innehåller underliga detaljer erbjuder låg eller ingen precision, då det inte tillåter andra att härleda resultatet. Exempelvis kan en medeltemperatur över en viss period verka rimlig, men med tillgång till underliggande temperaturobservationer kan användaren se standardavvikelsen och själv avgöra om mätningarna verka rimliga. Bilden nedanför föreställer sambandet mellan exakthet, precision, validitet och kommer från standarden ISO-5725-1. Standard förklarar generellt innebörden av av exakthet, precision och validitet med gruppering av träffar på en tavla. Validitet är graden av sanning, det vill säga att data mäter det som är avsett att mätas. Exempelvis kan mätningar som avser att mäta utomhustemperaturen påverkas om mätningarna görs nära en byggnad eller bredvid annan värmekälla vilket påverka validiteten.

Principer angående datakvalitet

- Ta reda på vilken detaljnivå av data de tilltänkta användarna är i behov av och motivera kostnaden med att tillhandahålla och underhålla data med ett tydligt syfte och målsättning som är kopplat till verksamhetsmål

- Prioritera att tillhandahålla några få efterfrågad datakällor med hög kvalitet (exakthet, precision och med hög sanningshalt) istället för många med lägre kvalitet

- Undvik att använda proprietära format som exempelvis EXCEL, PDF och Shapefile. Använd istället öppna format som inte kontrolleras av enskilda organisationer som exempelvis XML, JSON och GeoJson.

- Inrätta rutiner och processer för att säkerställa att datakvaliteten upprätthålls löpande och varnar om enheter av data saknas eller att mätvärden överstiger tillåtna gränsvärden

- Säkerställ att metadata är så komplett och beskrivande som möjligt, data som representerar komplexa objekt, validering och relationer mellan objekt behöver hierarkiska dataformat som XML och JSON, vilket erbjuder länkning till scheman som förklarande objekt, attribut och relationer

- Inkomplett och felaktig metadata medför att förtroende och användningsområdet för data minskar

- Grunddata har flera applikationsområden kontra färdiga sammanställningar, prognoser och rapporter. Förklara istället hur användaren själv kan göra egna sammanställningar

- Grunddata ger användaren möjlighet att använda egna algoritmer och uträkningar

- Behåll ursprungliga enheter om mätenheter för grunddata, om transformeras till andra mätenheter görs behöver detta förklaras

Senast uppdaterad 2021-04-04